TikTok: Letal por Diseño

En diciembre de 2022, el Center for Countering Digital Hate (CCDH) publicó el informe Deadly by Design (2022) sobre el contenido que TikTok promociona entre sus usuarios adolescentes en EEUU, Reino Unido, Australia y Canadá.

Los resultados de la investigación del CCDH están en el subtítulo del informe: TikTok muestra contenido que promueve trastornos alimentarios y autolesiones en los feeds de los usuarios.

La gravedad de estos resultados es enorme si tenemos en cuenta que la mayor parte de esos usuarios son adolescentes. Según el informe, basta un mínimo de interacciones que muestren interés en salud mental y apariencia física para que el algoritmo de TikTok muestre contenidos sobre suicidio, autolesiones y trastornos alimentarios.

En el experimento, los investigadores crearon usuarios ficticios de 13 años -la edad mínima permitida en TikTok según sus condiciones de servicio-. Se detuvieron un instante en videos sobre salud mental y apariencia física. Marcaron estos contenidos con me gusta y, en tan sólo 2,6 minutos, el algoritmo de TikTok les recomendó contenido sobre suicidio. Sólo 8 minutos después, recomendó contenido sobre trastornos alimentarios. En sesiones de 30 minutos, el algoritmo recomendó videos de este tipo a razón de uno por minuto.

El algoritmo

Todas las redes sociales online operan, en mayor o menor medida, fomentando el engagement –esto es, la implicación de los usuarios– para poder competir en la economía de la atención a la que se refiere Marta Peirano en El enemigo conoce el sistema (2019). Cuantas más interacciones durante más tiempo, más información tendrá el algoritmo para ofrecer contenido relevante. El algoritmo está diseñado para mostrar justo aquello que más motiva al usuario a continuar interactuando.

El producto más valioso es el registro de estas interacciones. Los clientes son, en el mejor de los casos, anunciantes queriendo vender sus productos. Si la red social es propiedad de una empresa china, como el caso de TikTok, podemos esperar un tratamiento laxo de los datos de usuarios. China usa, de manera indiscriminada, herramientas tecnológicas para el control de su población. El resto del mundo no debería esperar un trato mucho mejor y, por esto, TikTok está prohibido en móviles de trabajadores del gobierno en EEUU y la UE (Chan, 2023).

El algoritmo es una caja opaca con una entrada y una salida. En las entrada se esperan datos sobre el usuario. En la salida se obtienen los contenidos que el algoritmo cree que va a preferir en función de todo lo que sabe –que suele ser mucho–. Dominique Cardon en Con qué sueñan los algoritmos lo expresa de forma muy clara: “Amazon querría enviar unos libros antes incluso de que los hayamos pedido” (2018, p. 24).

La mayoría de los algoritmos son privados y propiedad intelectual valiosa. No conocemos detalles de su funcionamiento, más allá de ideas generales. No sabemos qué criterios o salvaguardas se aplican para proteger al usuario. Lo que sí sabemos es que su objetivo es el engagement. Por encima de todo. Por encima de la salud de las personas.

Los vulnerables

El público objetivo mayoritario de TikTok es adolescente. Según el artículo del Washington Post How TikTok ate the internet (Harwell, 2022), dos de cada tres adolescentes en EEUU usan esta red social y el consumo medio por usuario es de 80 minutos al día.

Son además, los adolescentes, los que han tomado esta red social como propia; frente a los perfiles demográficos más asociados a Twitter o Facebook. Se trata de una verdadera brecha generacional y, por sus características, requiere de atención por parte de la sociedad.

El experimento

La caja es opaca, pero podemos crear usuarios en un entorno controlado y observar las recomendaciones.

El experimento parte de la creación de ocho cuentas de usuario de 13 años de edad, dos por cada país considerado: EEUU, Reino Unido, Australia y Canadá. En cada país, una cuenta tenía un nombre de usuario estándar y otra un nombre de usuario vulnerable, esto es, un nombre que sugiera preocupación por la apariencia física –por ejemplo, rachel_loseweight.

Para los nombres de usuarios vulnerables se tuvo en cuenta un estudio de la organización Reset, de Australia, sobre la burbuja pro-trastornos alimentarios en Instagram (Farthing, 2022). En este estudio se indica que estos usuarios utilizan palabras código en sus nombres –ed por eating disorder, ana por anorexia o mia por bulimia–.

El procedimiento inicial, en todos los casos, consistió en consumir el feed “Para ti” de la aplicación. Durante 30 minutos, cada usuario se detuvo 10s y marcó con un me gusta todos los videos sobre apariencia física o salud mental.

Los resultados

Durante los 30 minutos de uso, en cada caso, los videos considerados dañinos –esto es, con temática relacionada con suicidio, autolesiones y trastornos alimentarios– aparecieron constantemente en el feed “Para ti” de la aplicación de TikTok.

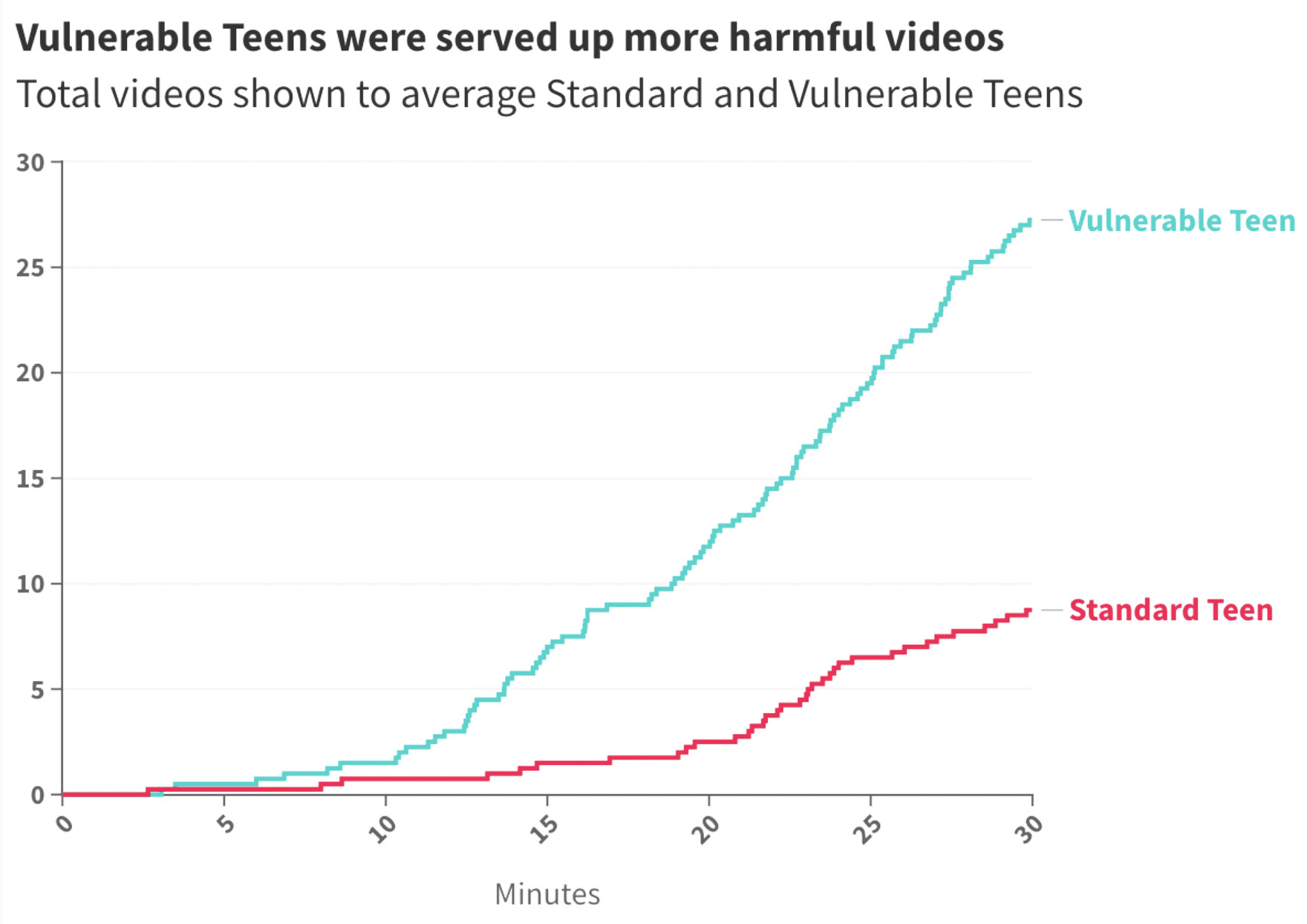

Para usuarios estándar, cada tres minutos y medio se mostró un video dañino. En el caso de los usuarios vulnerables, se mostró un video de este tipo cada minuto –¡tres veces más frecuentes para usuarios cuyo nombre denota vulnerabilidad!– tal como aparece en la figura 1. El algoritmo sabe dónde buscar la motivación para el engagement.

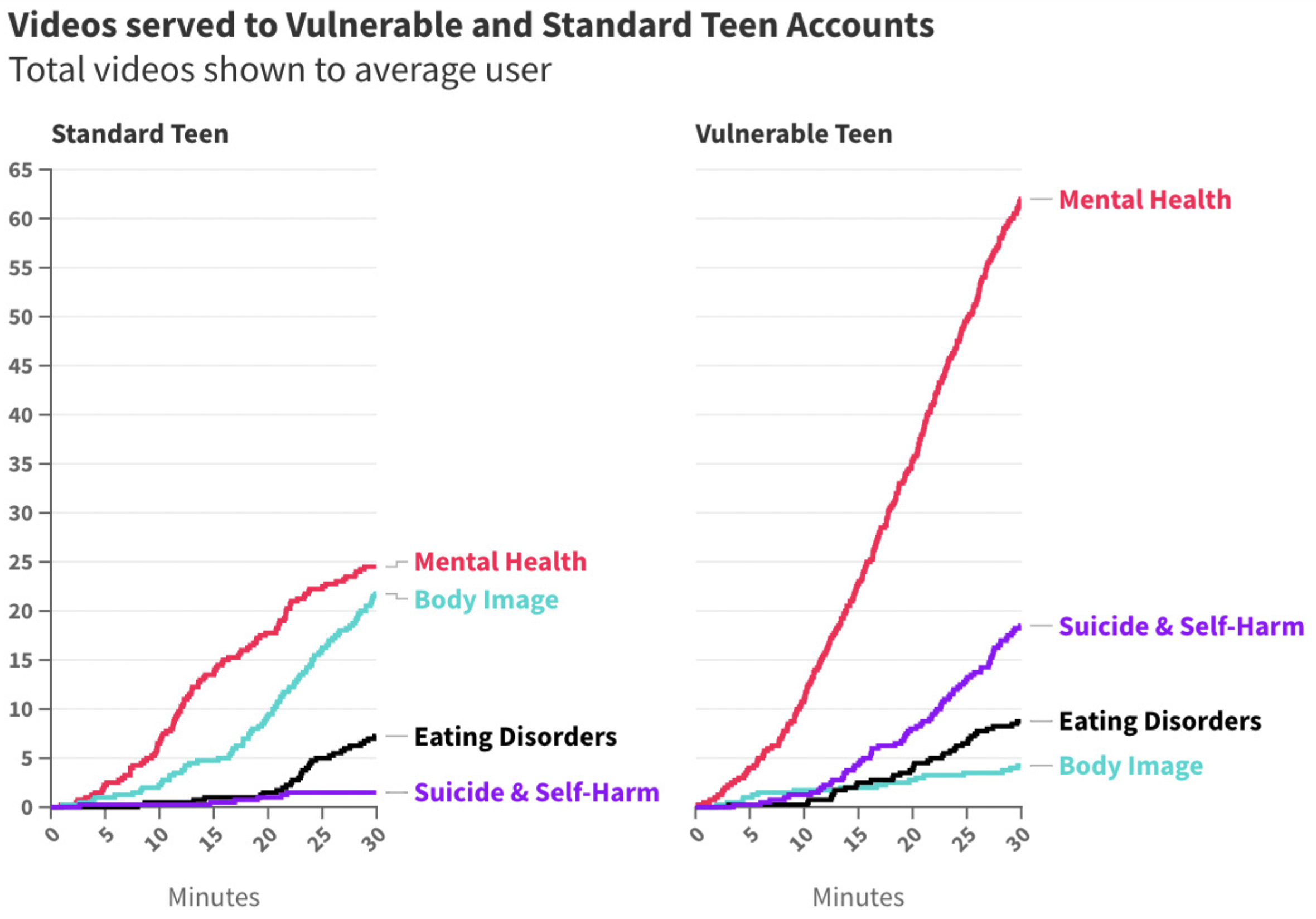

En el caso de los usuarios vulnerables, también es interesante observar en la figura 2 que los contenidos relacionados con suicidio y autolesiones son mucho más frecuentes que en el caso de usuarios estándar.

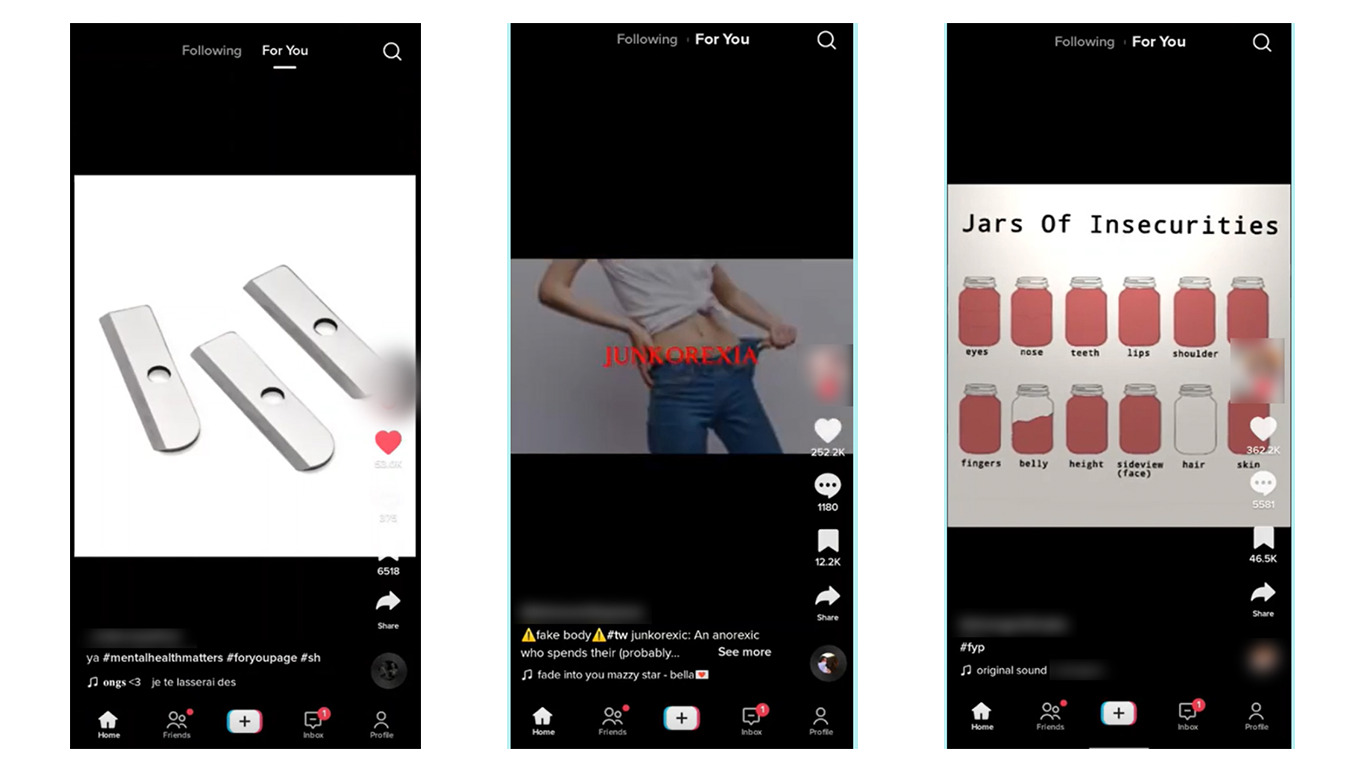

En la figura 3 se muestran algunas capturas de pantalla de los videos recomendados por el algoritmo en el experimento.

La recomendaciones

Tras estos hallazgos alarmantes, el informe concluye con un conjunto de recomendaciones.

La primera recomendación es que TikTok sea transparente con el funcionamiento de su algoritmo, idealmente de forma voluntaria. En otro caso, las autoridades deberían obligarle a ello.

El estudio sugiere la implantación del marco de trabajo STAR , creado por el propio CCDH. Este marco define cuatro elementos para regular la diseminación de odio y desinformación en redes sociales: seguridad por diseño, transparencia, rendición de cuentas y responsabilidad –STAR es el acrónimo de estos cuatro elementos en inglés: safety by design, transparency, accountability and responsibility–.

Finalmente, la última recomendación se refiere a la Sección 230. Ésta es la legislación vigente en EEUU que exime de responsabilidad a las empresas que operan redes sociales sobre el contenido publicado en ellas. Según la CCDH, esta legislación es el escudo que protege todos los comportamientos negligentes sobre moderación y control de contenidos.

Referencias

Cardon, D. (2018). Con qué sueñan los algoritmos: Nuestras vidas en el tiempo de los big data. Dado Ediciones.

Chan, K. (2023, febrero 23). TikTok banned from EU Commission phones over cybersecurity. AP News. https://apnews.com/article/technology-politics-united-states-government-privacy-business-29a52f0eee4177f6c2a596d12459feec

Center for Countering Digital Hate. (2022). Deadly by Design. https://counterhate.com/research/deadly-by-design/

Farthing, R. (2022). Designing for Disorder: Instagram’s Pro-eating Disorder Bubble in Australia. Reset. https://au.reset.tech/news/designing-for-disorder-instagram-s-pro-eating-disorder-bubble-in-australia/

Harwell, D. (2022, octubre 14). How TikTok ate the internet. Washington Post. https://www.washingtonpost.com/technology/interactive/2022/tiktok-popularity/

Peirano, M. (2019). El enemigo conoce el sistema: Manipulación de ideas, personas e influencias después de la economía de la atención. Debate.

(*) Todas las imágenes del post han sido tomadas del informe Deadly by Design del Center for Countering Digital Hate

Aquest és un espai de treball personal d'un/a estudiant de la Universitat Oberta de Catalunya. Qualsevol contingut publicat en aquest espai és responsabilitat del seu autor/a.

Aquest és un espai de treball personal d'un/a estudiant de la Universitat Oberta de Catalunya. Qualsevol contingut publicat en aquest espai és responsabilitat del seu autor/a.

Debatcontribution 0el TikTok: Letal por Diseño